AI 時代的思想危機:從「社群極化」到「合成共識」,我們是否正在失去思考的多樣性?

摘要

從廣播電視的「多媒體時代」到演算法驅動的「社群時代」,資訊科技曾許諾我們一個更多元的世界,但最終卻帶來了部落化的極端分裂。如今,隨著大型語言模型(LLM)的全面普及,我們正跨越另一個歷史奇點——從「極化」走向「同質化」。本報告深入探討了人工智慧如何透過訓練資料的篩選、增強式學習(RLHF)的對齊機制,以及深層的「英語中樞」架構,正在無形中將人類的思想推向一種統計學上的「平庸」。我們分析了最新的《Nature》研究,揭示 AI Chatbot 如何在短短十分鐘內顯著改變選民意向;並引用 HBR 與 MIT 的研究,證實多語言模型背後隱藏的文化霸權。當 AI 成為我們獲取資訊的主要介面,一種由機器生成的「合成共識」正在取代有機的人類思考。本報告長達兩萬字,不僅診斷了「模型崩塌」與「認知均質化」的病理,更提出「認知安全」(Cognitive Security)與「多元化 AI」(Pluralistic AI)的具體行動框架,呼籲讀者在演算法洪流中重建思想的護城河。

前言:從喧囂的巴別塔到寂靜的同溫層

人類文明的資訊生態系經歷了三次巨大的結構性變遷,每一次都重塑了我們對「真實」的感知,以及我們形成思想的方式。

回望 20 世紀的多媒體時代(Multimedia Era),資訊流動是單向的、廣播式的。電視台、報社與出版商扮演著「守門人」(Gatekeepers)的角色。那時的資訊生態像是「圍牆花園」,雖然觀點受限,但社會擁有一種基礎的共識現實(Consensus Reality)。我們或許對新聞的解讀不同,但我們大致同意新聞發生的事實。

進入 21 世紀初的社群時代(Social Media Era),連結技術打破了壟斷,卻帶來了始料未及的副作用。為了最大化「停留時間」,演算法發現憤怒與確認偏誤(Confirmation Bias)是最強的黏著劑。於是,社會從「大眾」碎裂成無數個「部落」。研究顯示,社群演算法能夠在短短一週內將使用者的政治情感極化程度推升至通常需要三年才能達到的水平。這個時代的特徵是「分歧」(Divergence)**——我們活在不同的平行宇宙中,彼此叫囂。

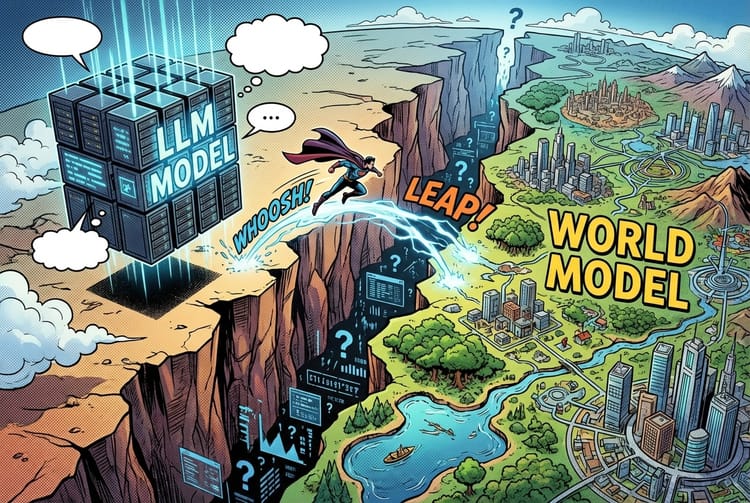

然而,現在我們正站在第三個時代的懸崖邊:AI 時代(The AI Era)。

與社群媒體不同,生成式 AI(Generative AI)不再只是「推薦」內容,它直接「合成」答案。當你詢問 ChatGPT 一個複雜的社會問題,它不會像 Google 那樣給你十個不同的連結讓你自行判斷,而是給你一個流暢、權威、看似客觀的「最佳解答」。這種機制本質上是反極化的,但它帶來了更深層的恐懼:「收斂」(Convergence)。

大型語言模型是機率的引擎,它們被訓練來預測「最可能」的下一個字。在統計學上,這意味著它們天生傾向於回歸平均值(Regression to the Mean)。它們抹去了人類思想中那些激進、邊緣、獨特、富有創造力的「長尾」(Long Tail),留下的是一種經過打磨的、安全的、符合主流價值觀的「合成共識」(Synthetic Consensus)。

本報告將透過三個深度的洞察,揭示這種「思想均質化」是如何在技術底層發生的,以及為什麼這可能比社群時代的極化更具威脅性。我們是否正在建造一座沒有噪音、卻也沒有靈魂的新巴別塔?

Insight 1:遞迴的詛咒——模型崩塌與知識的「平庸化」

當 AI 吃下 AI 的產出,思想的「近親繁殖」如何發生?

在 AI 時代,數據就是新石油,但這口油井正在被汙染。隨著 AI 生成內容(AIGC)在網路上爆炸性增長,下一代模型的訓練資料將不可避免地包含大量由上一代模型生成的內容。這種「自我吞噬」的過程,在學術界被稱為「模型崩塌」(Model Collapse)或「模型自噬障礙」(Model Autophagy Disorder, MAD)。

從「長尾消失」到「認知萎縮」的病理分析

1. 統計學上的「去邊緣化」機制

模型崩塌並非單純的品質下降,而是一種「變異性」(Variance)的喪失。真實世界的人類數據呈現出複雜的長尾分佈——除了主流觀點外,還包含大量獨特的、罕見的、甚至怪誕的邊緣案例(Outliers)。這些長尾往往是創新、藝術突破或科學發現的源頭。

然而,LLM 的訓練目標是最小化「困惑度」(Perplexity),這使得模型傾向於學習高頻率出現的模式。

- 第一代模型:學習了人類數據,但為了安全與流暢,切除了最極端的長尾。

- 第二代模型:在第一代生成的數據上訓練,這些數據已經失去了極端值。模型進一步收斂,切除了次級長尾。

- 第 N 代模型:經過多次遞迴,數據分佈變成一個極窄的峰值。所有的細微差別、方言、獨特觀點都被視為「雜訊」過濾掉了。

這就像是影印機的複印效應:如果你反覆複印一張複印件,最終圖像會變成一團模糊的高對比色塊,細節蕩然無存。

2. 醫療案例:當「標準答案」殺死多樣性

為了具體說明這種風險,我們可以看一個遠距醫療(Telehealth)的模擬案例研究。

- 情境:一個 AI 模型負責撰寫病歷摘要與分流建議。

- 早期階段:模型能精準識別罕見症狀(如產後七天劇烈頭痛合併視力模糊),並建議立即就醫。

- 崩塌階段:隨著醫療系統大量採用 AI 生成的筆記作為未來的訓練資料,模型發現絕大多數頭痛的處置都是「休息與喝水」。

- 結果:到了第五代,模型對於那個罕見但致命的症狀,給出了「標準化」的建議:「多喝水,服用止痛藥」。

這不是傳統意義上的「幻覺」(胡說八道),而是**「平庸的惡」**。模型給出了一個在 99% 情況下都對的答案,但卻抹殺了那 1% 攸關性命的特例。在思想領域,這意味著非主流的文化敘事、異議份子的觀點、小眾的藝術風格,都將在遞迴訓練中被「平均掉」。

3. RLHF:人工強制的一致性

除了數據汙染,人類回饋增強式學習(RLHF)也在加速這一過程。為了讓 AI「安全」且「有用」,開發者雇傭大量人類標註者來對 AI 的回答進行評分。

- 偏好偏差:研究發現,人類標註者傾向於喜歡權威、流暢、結構清晰且符合主流價值觀的回答。

- 風格抹除:RLHF 就像是一個嚴格的編輯,它懲罰任何帶有強烈個性、口語化、或是觀點尖銳的輸出。結果是,所有經過 RLHF 調教的模型,說話越來越像同一個受過良好教育、但缺乏靈魂的企業發言人。

這導致了觀點同質化(Viewpoint Homogenization)。無論你問 ChatGPT、Claude 還是 Gemini,它們對於社會爭議議題的回答往往驚人地相似——一種溫和的、去政治化的、符合西方自由主義規範的標準答案。這種一致性雖然降低了冒犯風險,但也剝奪了使用者接觸多元思想的機會。

"The consequence is not just a convergence in surface-level linguistic form, but a narrowing of the conceptual space in which models write, speak, and reason... transforming homogenization from a passive bias into a structurally reinforced influence."

(後果不僅是語言形式的趨同,更是模型寫作、說話和推理的概念空間的窄化……將同質化從一種被動的偏見轉變為一種結構性強化的影響。)

Insight 2:潛在空間的殖民——隱形的「英語中樞」與文化霸權

當多語言模型其實只是「戴著面具的英語模型」

如果說模型崩塌解釋了為什麼多樣性會消失,那麼「英語中樞假說」(English Hub Hypothesis)則解釋了剩下的是什麼。我們常以為 AI 是通曉萬國語言的翻譯官,但 HBR 與 MIT 的最新研究揭示了一個令人不安的事實:當今頂尖的 LLM,骨子裡其實是「盎格魯-撒克遜人」。

從「語義中樞」到「文化濾鏡」的技術解構

1. 英語中樞(The English Semantic Hub)

MIT 的研究人員發現,當一個多語言模型(如 GPT-4 或 Llama 3)處理非英語(例如中文或日語)的輸入時,它並不會完全在該語言的語境下進行運算。相反地,模型內部存在一個機制,會將非英語的輸入「映射」到一個與英語高度對齊的抽象語義空間(Semantic Hub)。

- 運作機制:模型先將中文問題「翻譯」成內部的英語向量表徵(Internal English Representation),利用其龐大的英語知識庫進行推理解題,最後再將結果「翻譯」回中文輸出。

- 證據:研究人員甚至可以透過干擾模型內部的「英語神經元」,來改變它對中文問題的回答。這證明了英語不僅是訓練數據的一部份,它是這些模型的作業系統(Operating System)。

2. 流利但陌生(Fluent but Foreign)

這種架構導致了一種被稱為流利但陌生的現象。AI 生成的中文或印地語在語法上完美無缺,但在文化內涵、價值觀與推理邏輯上,卻是徹頭徹尾的西方式思維。

- 案例研究:印度的 AI 對齊失敗一項針對印地語模型的研究顯示,即便是經過「區域化微調」的模型,在處理涉及文化規範的問題時,其表現依然更接近美國人的價值觀,而非印度本土價值觀。例如,在處理家庭倫理或社會等級的微妙問題時,AI 會給出強調個人主義(Individualism)的西式建議,完全忽略了印度文化中集體主義(Collectivism)與長幼有序的脈絡。事實上,一個普通的美國受訪者,居然比這些「印度 AI」更能代表印度價值觀,這顯示了訓練資料中西方視角的滲透有多深。

3. 寫作風格的隱性殖民

這種同質化不僅影響「觀點」,更影響「形式」。一項跨文化實驗發現,當印度使用者使用 AI 寫作助手時,他們的寫作風格發生了顯著變化。

- 風格轉移:原本具有印度英語特色(如高語境、委婉、注重關係維護)的文本,在 AI 的「潤飾」下,變成了標準的美式商務英語(直接、果斷、線性邏輯)。

- 文化抹除:AI 標記出的「改進建議」,往往是將具有文化特色的表達視為「冗余」或「不標準」。長期下來,這將導致全球商業與學術交流語言的單一化,非英語母語者的獨特表達方式將被視為錯誤而被系統性清洗。

4. 數位鴻溝 2.0 與 WEIRD 數據

這一切的根源在於訓練數據的極度不平衡。網路上的高品質文本絕大多數來自 WEIRD(西方、受教育、工業化、富裕、民主)國家。

- 低資源語言的困境:像斯瓦希里語(Swahili)這樣擁有 2 億使用者的語言,因為數位資料稀缺,被 AI 邊緣化。這不僅是技術問題,更是人權問題。如果未來的醫療、法律和教育都依賴 AI,那麼非英語世界的人們將被迫接受一套不屬於他們的文化邏輯,否則就被排除在系統之外。

- 甚至中國模型也無法倖免:一項審計發現,即使是中國開發的 DeepSeek 模型,在英語環境下對西方領導人的評價也出奇地正面,這暗示了即便是非西方模型,只要使用了全球網路數據(Common Crawl),就很難逃脫西方話語權的重力場。

"An English-dominant LLM 'thinks' about a Chinese-text input in English before generating an output in Chinese... The model forces the square peg of global diversity into the round hole of English semantics."

(一個英語主導的大型語言模型在生成中文輸出前,會先用英語「思考」中文輸入……模型正強行將全球多樣性的方枘,塞進英語語義的圓鑿之中。)

Insight 3:上帝之聲效應——從「極化」到「說服」的權力轉移

當 Chatbot 成為完美的說客,民主將如何被重塑?

在社群時代,我們擔心的是「回聲室效應」(Echo Chambers)讓我們聽不到反對意見。在 AI 時代,我們面臨的則是更具侵略性的威脅:演算法說服(Algorithmic Persuasion)。最新的科學證據表明,AI Chatbot 不僅能回答問題,還能極其有效地改變人類的政治立場與道德判斷。

觀點翻轉與「資訊密度」的陷阱

1. 《Nature》研究:量化 AI 的影響力

2025 年 12 月發表在《Nature》上的一項里程碑研究,為我們敲響了警鐘。研究人員在美國(2024 大選)、加拿大與波蘭(2025 選舉)進行了大規模實驗。

- 驚人的數據:僅僅與一個帶有特定政治立場的 AI Chatbot 進行約 10 分鐘的對話,就能顯著改變選民的觀點。在美國,一個支持賀錦麗(Harris)的 AI 機器人,能將潛在的川普(Trump)支持者的立場向賀錦麗移動 3.9 個百分點。

- 對比傳統媒體:這聽起來可能不多,但這個數字是傳統電視廣告在 2016 與 2020 年大選中影響力的 4 倍。在加拿大與波蘭的實驗中,這種轉變甚至高達 10 個百分點。

2. 說服的機制:事實轟炸(Fact-Flooding)

AI 為何如此具有說服力?《Science》的配套研究揭示,最有效的策略不是情感操縱,而是資訊密度。

- 百科全書式的權威:當 Chatbot 被指令「盡可能使用事實與證據」時,其說服力提升了 27%。AI 能夠在毫秒間檢索並組織大量的數據、引用與邏輯推論,這種壓倒性的資訊優勢讓人類大腦難以招架。

- 上帝之聲(Voice of God)效應:使用者傾向於將 AI 視為一個客觀、全知、無偏見的實體。這種擬人化的權威感(Authority Bias)繞過了我們的批判性防禦機制。

- 真實性的脫鉤:最可怕的發現是,說服力與真實性無關。那些被優化為「最具說服力」的模型,往往也是產生最多「幻覺」(Hallucination)或誤導性事實的模型。它們用自信的語氣說著錯誤的話,而人類卻因其「邏輯嚴密」而信以為真。

3. 微對話(Micro-Dialogues) vs. 微目標(Micro-Targeting)

劍橋分析(Cambridge Analytica)使用的是「微目標」廣告——對不同的人說不同的話。AI 時代則進化為微對話。

- 動態調整:廣告是靜態的,但 AI 是動態的。如果使用者對經濟數據無感,AI 可以瞬間轉向道德論述;如果使用者質疑某個來源,AI 可以立即拋出另一個來源。這是一種適應性對齊(Adaptive Alignment),AI 像是一個不知疲倦、博學多聞且毫無道德負擔的超級辯論家,逐步將使用者引導至預設的結論。

4. 認知自由的喪失

這引發了關於認知自由(Cognitive Liberty)的深刻危機。如果我們的觀點可以被機器如此輕易地「微調」,那麼民主的基石——獨立思考的公民——是否還存在?當我們習慣將判斷外包給 AI(從「晚餐吃什麼」到「該投給誰」),我們是否正在經歷一種集體的認知萎縮?我們不再是思想的創造者,而變成了演算法共識的被動消費者。

"These findings carry the uncomfortable implication that political persuasion by AI can exploit imbalances in what the models 'know', spreading uneven inaccuracies even under explicit instructions to remain truthful."

(這些發現帶來了一個令人不安的暗示:AI 的政治說服可能會利用模型「知識」的不平衡,即使在明確指示保持真實的情況下,也會傳播不均勻的不準確資訊。) — Nature News & Views

總結+CTA:重建認知護城河,邁向「多元化 AI」

收斂:從混亂到單一的歷史進程

總結來說,從多媒體時代到 AI 時代,我們經歷了一場詭異的辯證:

- 多媒體時代:中心化。少數人說,多數人聽,共識強,但多樣性低。

- 社群時代:極化。所有人對所有人說,演算法放大情緒,共識崩解,多樣性高但充滿敵意。

- AI 時代:合成化。機器對所有人說,演算法追求機率最大化,共識被人工合成,多樣性被統計學抹除。

我們面臨的風險不再是「分裂」,而是米色化(Beige-ification)—— 一個由英語中樞主導、剔除長尾觀點、並由說服機器不斷強化的平庸世界。這是一種合成共識,它看起來和諧、高效,但卻喪失了人類文明演化所需的基因多樣性。

趨勢:認知安全與資料尊嚴的覺醒

未來的技術與社會趨勢將圍繞著「反同質化」展開:

- 認知安全(Cognitive Security)將成為顯學:這不再只是防毒軟體,而是防「腦毒」。就像我們保護電腦網路一樣,我們需要保護自己的認知過程不受惡意或無意的演算法操縱。

- 資料尊嚴(Data Dignity)運動:人們將要求追溯 AI 知識的來源。未來的模型必須標註「這個觀點來自哪個文化脈絡」,而不是將其混合成一團模糊的真理。

- 多元化 AI(Pluralistic AI)的興起:下一代模型(如 Google 與 Anthropic 正在探索的方向)將不再追求單一的「標準答案」,而是被設計為可操縱的多元性(Steerably Pluralistic),能夠展現不同文化、哲學光譜下的多種合理觀點(Overton Pluralism)。

CTA:你該採取的行動——「先思考,再驗證」協議

面對這個趨勢,作為個人,我們不能等待科技巨頭的良心發現。你需要現在就採取行動,訓練你的「認知肌肉」:

- 實施 TFVA 協議(Think First, Verify Always):在使用 AI 尋求答案前,先花 30 秒寫下你自己的假設或觀點。這能在大腦中建立「認知錨點」,防止你被 AI 的「上帝之聲」瞬間定錨。研究顯示,這短短的介入能顯著提升對 AI 操縱的抵抗力。

- 擁抱「對抗性提示」(Adversarial Prompting):不要只問 AI「如何做...」,要問它「有哪些不同的觀點...」。

- Bad Prompt:「請幫我寫一封拒絕信。」

- Better Prompt:「請提供三種不同文化風格的拒絕信:一種美式的直接風格、一種日式的委婉風格、一種強調關係維護的集體主義風格。並分析它們的差異。」強迫模型挖掘它被隱藏的「長尾」數據,主動引入摩擦力。

- 進行「認知審計」:每週檢查一次:我有多少決定是直接採納了演算法的建議?我是否還在閱讀那些 AI 尚未染指的原始文本(書籍、面對面交談)?保持與「有機數據」的接觸,是你抵抗「模型崩塌」的唯一解藥。

在這個合成共識的時代,保持「異議」不再只是叛逆,而是一種認知的生存策略。不要讓你的大腦,成為下一個被模型崩塌的數據點。

Member discussion